McCloskeys reclama el rifle AR-15 después de una batalla legal de mucho tiempo en St. Louis

NUEVO¡Ahora puedes escuchar artículos de Fox News!

La pareja de St. Louis que se volvió viral en 2020 por empuñar armas a medida que los manifestantes de Black Lives Matter marcharon fuera de su propiedad han recuperado la posesión de su rifle semiautomático.

Después de una lucha legal compleja y compleja para recuperar sus armas Después de que fueron incautados por las autoridades hace más de cinco años, la policía devolvió el AR-15 a los abogados de St. Louis Mark y Patricia McCloskey.

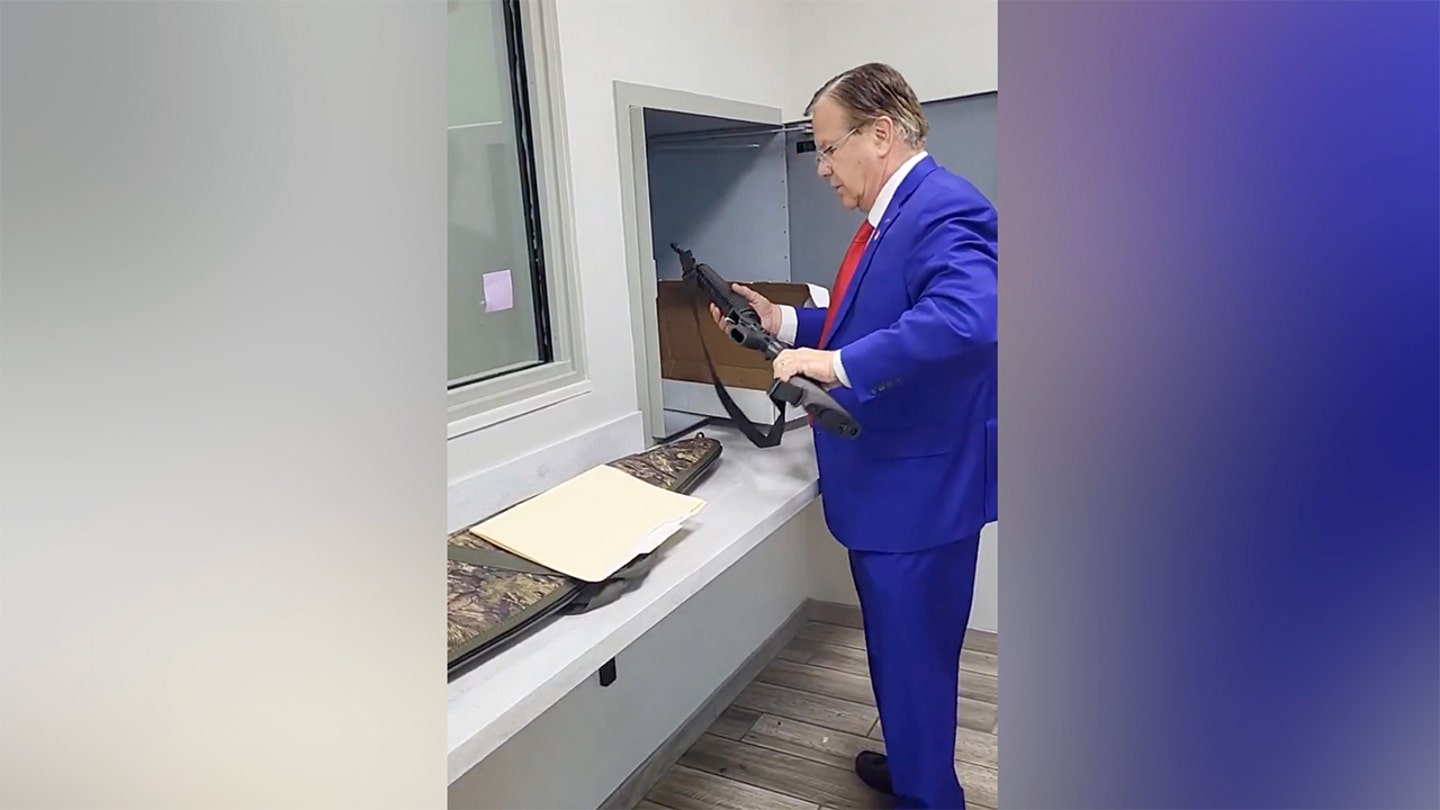

«Solo tomó 3 demandas, 2 viajes al Tribunal de Apelaciones y 1,847 días, ¡pero recuperé mi AR15!» Mark McCloskey Publicado en su X Cuenta el viernes, junto con varias fotos de él llevando el arma.

«Defendimos nuestra casa, fuimos perseguidos por la izquierda, manchados por la prensa y amenazados con la muerte, pero nunca retrocedimos».

En una publicación X separada, Mark McCloskey también compartió un video de sí mismo recuperando el rifle de una estación de policía.

Después de una lucha legal compleja y compleja para reclamar sus armas, la policía ha devuelto un AR-15 a los abogados de St. Louis Mark y Patricia McCloskey. (@mccloskeyusa a través de x)

«Es posible que solo haya valido $ 1,500 o algo así, y me costó mucho tiempo y mucho esfuerzo recuperarlo, pero tienes que hacerlo», dijo Mark McCloskey a Fox News Digital, y agregó que posee otras armas. «Tienes que hacerles saber que nunca retrocederás, nunca te rendirás».

Dijo que espera que su pistola, manejada por Patricia McCloskey, durante la confrontación, sea devuelta la próxima semana. El AR-15 terminó en posesión del Departamento de Policía Metropolitana de St. LouisMientras la pistola terminó en posesión del Departamento del Sheriff de St. Louis, agregó.

«Todos y cada uno de nosotros poseen una responsabilidad personal de nuestra libertad y nuestra República Democrática», dijo Mark McCloskey.

En junio de 2020, un video de los McCloskeys que comían con armas de fuego tomó Internet por asalto después de que un enjambre de manifestantes de Black Lives Matter rompió una puerta de hierro e ignoró un letrero de «no intrusión» en su calle privada.

Patricia y Mark McCloskey atraen sus armas a los manifestantes cuando ingresan a su vecindario durante una protesta contra la alcaldesa de St. Louis, Lyda Krewson, en St. Louis el 28 de junio de 2020. (Reuters)

La pareja, que dijo que se sentían amenazadas, se armaron antes de salir para alejar a la multitud, que se dirigía a la casa del ex alcalde. Nadie resultó herido.

Después del incidente, los McCloskeys fueron incautados por la policía, y fueron acusados de uso ilegal de un arma por el ex fiscal demócrata de St. Louis, Kim Gardner. Poco después, el fiscal general de Missouri, Eric Schmitt, se mudó para desestimar los cargos presentados por Gardner.

En 2021, los McCloskeys se declararon culpables de asalto de cuatro grados delitos menores y acoso en segundo grado, pero luego se les otorgó un perdón por ex gobernador de Missouri Mike Parson.

El ex gobernador de Missouri, Mike Parson, entrega la dirección del estado del estado el 18 de enero de 2023 en Jefferson City, Missouri. (AP Photo/Jeff Roberson)

El mes pasado, un tribunal de apelaciones de Missouri confirmó la expunción de las condenas por delitos menores de McCloskeys, que, según la ley estatal, significa que es como si el incidente nunca hubiera sucedido, dijo Mark McCloskey.

«Si ha sido perjudicado, si el gobierno izquierdista ha sido extralimitado, no puede darse por vencido», dijo Mark McCloskey a Fox News Digital. «No puedes dejar que tengan una pulgada».

Haga clic aquí para obtener la aplicación Fox News

La Oficina del Sheriff de St. Louis y el Departamento de Policía Metropolitana de St. Louis no respondieron de inmediato a la solicitud de comentarios de Fox News Digital.